Comment tirer profit des résultats

d’un test AB … même s’il n’est pas concluant ?

Les résultats de votre test AB sont arrivés et à première vue, le test n’a pas été très concluant. Vos équipes sont déçues… Ils pensaient que les changements augmenteraient les recettes. Alors comment allez-vous pouvoir apprendre quelque chose à partir de ce test non-concluant ? Vous ne vous en doutez pas mais les résultats probants nous mentent aussi parfois.

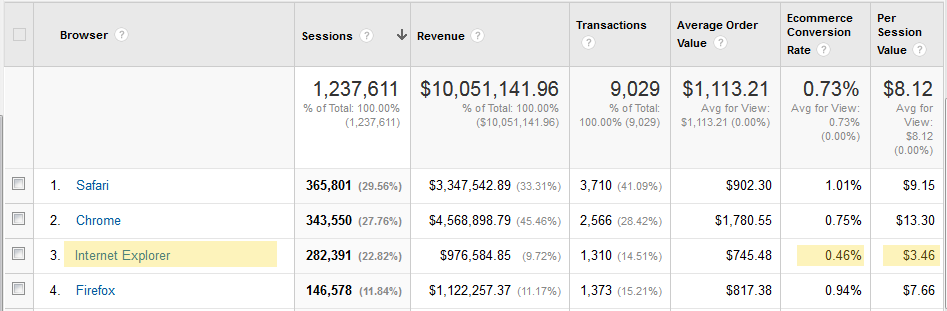

Alors prenons en exemple les résultats ci-dessous : lorsqu’un test se termine, il faut analyser les résultats dans son ensemble pour s’assurer qu’il y a plus que ce que nous avons sous les yeux. Nous appelons cette analyse : une analyse post-test. Dans ce cas, en isolant un segment de trafic de la variation A, il est clair qu’un navigateur a sous-performé par rapport aux autres.

Performance de la variation A

Les visiteurs d’Internet Explorer ont considérablement

sous-performés par rapport aux 3 autres navigateurs

Les visiteurs venant d’Internet Explorer ont un taux de conversion de moins de 0,50% par rapport aux autres navigateurs et génèrent un tiers du revenu par session. Ce n’était pas le cas sur la version originale. Quelque chose ne va pas avec cette variation de test. Malgré un effort (d’assurance qualité) qui comprenait tous les navigateurs populaires, une erreur a été introduite dans le code de test.

L’analyse post-test a démontré qu’en corrigeant cela produirait une augmentation de 13% du taux de conversion et 19% d’augmentation de la valeur par session. Et de ce fait, nous aurions un test gagnant. Conversion Sciences, experts de la conversion, explique qu’il est nécessaire de mettre en place un processus rigoureux pour s’assurer que des erreurs comme celles-ci soient très rares, mais qu’elles se peuvent toujours se produire. Dans tous les cas, il est important de savoir tirer profit d’une analyse post-test lorsque celle-ci arrive.

Voici un aperçu des questions pertinentes que l’on peut se poser en effectuant une analyse post-test, pour ensuite être en mesure de tirer profit de test peu concluant.

Une de nos variations a-t-elle gagné ?

La première question qui vous viendra à l’esprit sera : est-ce que l’une de nos variations a gagné ?

Il y a 2 possibilités d’interprétation lorsque nous examinons les résultats d’un Test AB :

→ Il n’a pas été concluant : aucune des variations ne bat la version originale. Les hypothèses nulles n’ont pas été réfutées.

→ Une ou plusieurs variations battent la version originale d’une manière statistiquement significative.

Parler d’analyse post-test n’est pas un terme très juste car l’analyses se fait tout au long du processus de test. Cela dit, lorsque vous observez les résultats d’un test AB, la première chose à savoir est si la variation a été gagnante, perdante ou non-concluante. Vérifiez que les gagnants soient bien gagnants car on cherche des résultats qui soient scientifiquement valides (vrais et reproductibles).

Votre version B a battu la version (originale) A de 4% : vous vous dites que c’est beaucoup trop faible comme un gain et vous n’allez pas perdre du temps à l’implémenter. Voyez les choses autrement :

– Si votre site original est assez bon, c’est normal d’avoir un gain de 1%, 4% ou 8%.

– Si votre site est peu performant, il est facile d’exécuter des tests qui lift à 50% !

L’important, c’est de mettre en perspective les lifts sur 12 mois. Si vous augmentez votre taux de conversion de 5% chaque mois, au final l’impact sur le revenue sur 12 mois pourrait être très positif ! Il ne faut donc pas ignorer les petits gains.

Quels types d’erreurs pouvons-nous faire ?

Pour éviter les erreurs de jugement, vérifiez d’abord les résultats de votre outil de test par rapport à vos analyses. Il est très important que votre outil de test envoie des données à votre outil analytics indiquant quelles variations sont vues par quels segments de visiteurs.

Mêmes avec les outils de test qui ne fournissent que des résultats de qualité et il est possible de constater des erreurs techniques. Nous pouvons donc toujours reproduire les résultats de notre test AB en utilisant les données analytiques et ainsi constater : Chaque variation a-t-elle obtenu le même nombre de conversions ? Les recettes ont-elles été déclarées avec exactitude ?

Il est préférable de regarder à deux fois pour éviter les erreurs en veillant à ce que la taille de l’échantillon soit suffisante et en utilisant une structure de test AB approprié. Pour vérifier s’il y a assez d’échantillon et que vous pouvez faire confiance au résultat du test, regardez si les chiffres rapportés par l’outil de test correspondent à ceux retrouvés dans l’outil d’analyse, à la fois pour le taux de conversion et le revenu par visite.

Les segments clés ont-ils été performants ?

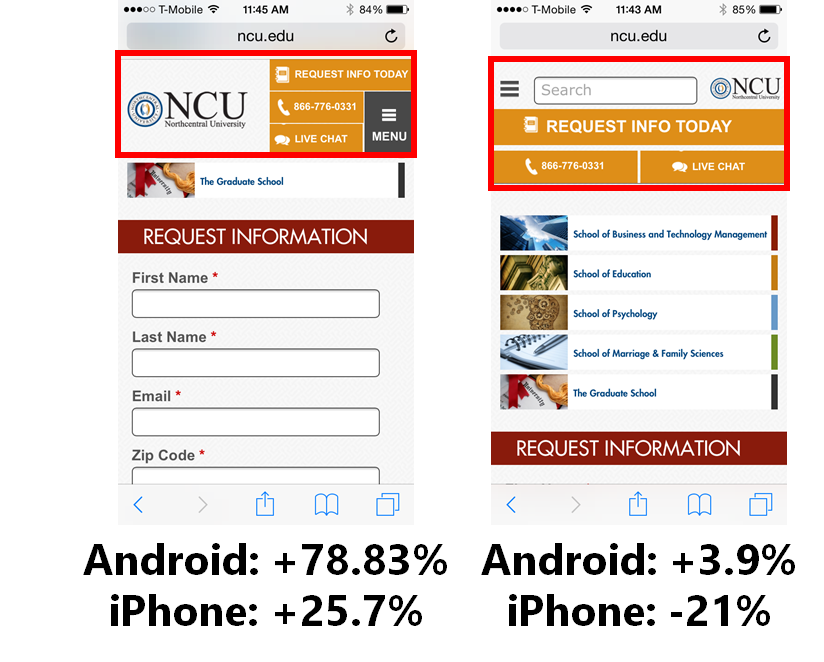

Dans le cas d’un test non-concluant, il faut se pencher sur les différents segments du trafic afin de les examiner. Par exemple, vous avez eu un résultat non-concluant sur le trafic des smartphones dans lequel les visiteurs Android ont adoré votre variation, mais les visiteurs d’iOS l’ont détesté. Les résultats se sont donc annulés mutuellement. Pourtant, nous aurions manqué une information importante si nous n’avions pas regardé de plus près.

Les visiteurs réagissent différemment selon leur appareil,

leur navigateur et leur système d’exploitation

D’autres segments peuvent fonctionner différemment, comme par exemple :

– Retour visiteurs vs. Nouveaux visiteurs

– Navigateurs Chrome vs. navigateurs Safari vs. Internet Explorer vs. …

– Trafic organique vs. trafic payé vs. trafic de référence

– Le trafic de messagerie vs. le trafic des médias sociaux

– Acheteurs de produits haut de gamme par rapport aux acheteurs non premium

– Visiteurs de la page d’accueil vs. participants internes

Ces segments seront différents pour chaque entreprise, mais apporteront des connaissances qui engendreront de nouvelles hypothèses, voire offriront des façons de personnaliser l’expérience des utilisateurs. Comprendre comment les différents segments se comportent est fondamental pour une bonne analyse des tests. Mais, il est également important de ne pas trop diviser les résultats en nombreux segments ou dans différents outils d’analyse. Vous pouvez souvent rencontrer des constats contradictoires.

Le revenu devrait toujours être considéré comme le critère auquel il faut prêter le plus d’attention car le taux de conversion n’est, après tout, qu’un résultat avec un ascenseur de conversion. Gardez en mémoire qu’il ne faut pas rejeter un test AB sous prétexte qu’il a des résultats non-concluants, car cela peut arriver assez souvent.

En plus de comprendre comment les changements testés ont eu une incidence sur chaque segment, il est également utile de comprendre où ces changements ont eu le plus d’impact dans la navigation du client.

Benjamin Cozon, COO chez Uptilab explique :

Benjamin Cozon, COO chez Uptilab explique :

Nous devons considérer que la fin de la phase d’exécution d’un test est en fait le début de l’analyse. Pourquoi chaque variation fournit-elle un taux de conversion particulier ? Dans quels cas mes variations ont-elles une différence, positive ou négative ? Afin de mieux répondre à ces questions, nous essayons toujours de déterminer quels segments d’utilisateurs sont les plus flexibles aux changements qui ont été faits.

Une façon de procéder est d’aérer les données avec des dimensions basées sur la session ou sur l’utilisateur. Voici quelques-unes des dimensions que nous utilisons pour la plupart de nos tests :

– Type d’utilisateur (nouveau visiteur/ visiteur récurrent)

– Prospect / Nouveau client / Client récurrent

– Chaîne d’acquisition

– Type de page de destination

Ce type d’aération des données nous aide à comprendre l’impact de changements spécifiques pour les utilisateurs par rapport à leur lieu spécifique dans la navigation du client. Avoir ces informations supplémentaires nous aide également à bâtir une solide base de connaissances et à communiquer efficacement dans toute l’organisation.

Enfin, bien que ce soit une excellente idée d’avoir un processus rigoureux en matière d’assurance qualité (QA) pour vos tests AB, certaines informations peuvent encore vous glisser entre les doigts. Lorsque vous examinez les segments de votre trafic, vous pouvez trouver un segment qui a été mal réalisé.

Ces changements peuvent-ils affecter la qualité des leads ?

L’analyse post-test nous permet d’être sûr que la qualité de nos conversions soit élevée. Et il est facile d’augmenter les conversions. Mais est-ce que les visiteurs convertis achètent-ils autant que ceux qui ont vu la version originale ? Dans l’analyse post-test, nous pouvons examiner la valeur moyenne de la commande pour chaque variation pour voir si les acheteurs ont acheté autant qu’avant. Nous pouvons examiner les marges bénéficiaires générées par les produits achetés. Si les revenus par visite augmenteraient, les bénéfices suivraient-ils ?

Si un test n’est pas concluant, nous pensons qu’il faut passer rapidement à la prochaine grande idée ou tester sur une segmentation plus ciblée. Plus vous allez travailler sur un segment fragmenté, moins vous allez en retirer des résultats concluants et perdre la qualité des leads (et en plus vous gaspillez votre temps à reconduire le test).

La qualité d’un lead est importante, de deux points de vue. Tout d’abord, qualitativement : la page challenger produit quelque chose qui est susceptible de réduire ou d’augmenter la valeur du lead ? Deuxièmement, quantitativement : comment pouvons-nous suivre les leads afin que nous puissions nous assurer que nous avons augmenté notre bénéfice net ?

⇒ A noter : Vous n’y avez peut être pas pensé (ou osé) mais sachez que publier des enquêtes sur la version testée peut vous permettre d’identifier des possibles axes d’amélioration !

Pourquoi ?

En fin de compte, nous voulons répondre à la question: Pourquoi ?

Pourquoi une variation a-t-elle gagné ? Pourquoi avons-nous obtenue le résultat que nous avons sous les yeux ? Qu’est-ce que ce résultat nous apprend sur nos visiteurs ?

Il s’agit d’un processus abstrait, mais demander pourquoi a 2 effets primaires :

– Cela développe de nouvelles hypothèses pour tester

– Cela nous amène à réorganiser la liste des hypothèses sur la base de nouvelles informations

Notre objectif est d’apprendre comme nous testons, et de se demander pourquoi est la meilleure façon de renforcer notre apprentissage.

Participer à la discussion